Всім привіт! Сьогодні хочу поговорити про дублікати сторінок на сайті. Дублікати сторінок – це абсолютно однакові по вмісту контенту сторінки на сайті, але мають різні URL. Пошуковики індексують ці сторінки, як дві різні. так як адреси у них відрізняються. А, як вам відомо, це буде не унікальним контентом, який в свою чергу призведе до зниження довіри пошуковика і зниження позицій сайту. Розглянемо один з численних способів видалення дублікатів сторінок з пошуку.

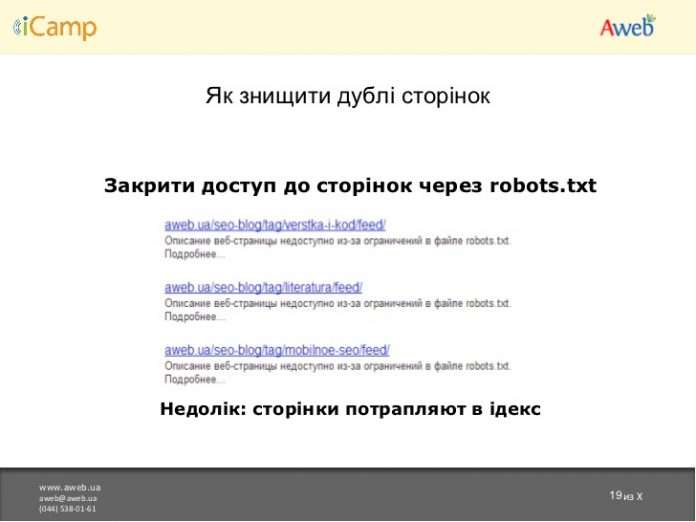

Як прибрати дублі сторінок на сайті через robots.txt

Для того щоб прибрати дублі сторінок за допомогою robots.txt перше, що потрібно налаштувати файл. Він лежить в кореневій директорії вашого сайту. Якщо ж такий файл не знаходиться, то його потрібно створити. Саме з нього пошуковики зчитують інформацію про те, як індексувати сайт.

У Robots міститься потрібна для пошукових ботів інформація, а саме перелік сторінок, які можна відвідувати, які не можна, який основний домен сайту, де знаходиться карта сайту і так далі.

Як створити robots?

Створити такий файл – просто. Досить зробити .txt документ з назвою «robots» і завантажити його в корінь сайту. У файлі потрібно прописати такі дані, як: User-agent, Allow, Disallow, Host. Приклад:

Приклад файлу robots.txt

User-agent: *

Allow: /

Disallow: /tag

Host: seo-infa.ru

|

1 2 3 4 |

User-agent: * Allow: / Disallow: /tag Host: seo-infa.ru |

Ну це необхідні речі. А можна ще шлях до xml карти сайту прописати…

User-agent містить інформацію про пошукових системах, для яких вказувалися правила. Allow вказує список адрес, які дозволені для індексації. Disallow – визначає перелік заборонених для індексації адрес. Host повідає пошуковій системі, який домен у сайту є основним, з www або без, наприклад.

Рекомендую до прочитання: Навіщо створювати сайт?

Так, це вважається? як два різних домену. При реєстрації домену одночасно фіксується і його дзеркало. З технічного боку це виглядає, як два різних домену, але з однаковим змістом, тому потрібно вказати який з них головний, а який дзеркальний. Таким чином, пошукова система, відвідавши зеркало\robots.txt і розшифрує, що це і є додатковий домен.

Видалення дублів з допомогою robots.txt

Ну ось, robots.txt зробили. Наступним кроком стає безпосереднє видалення дублів з сайту. Конкретні дії можна сказати, знаючи хоча б, який у вас движок, так і цього мало, якщо чесно, треба знати адресу сайту.

А як же тоді? Та все просто. Ви подумайте, які сторінки на сайті у вас дублюються, де дублюються частини вмісту. Часто буває, що це всякі теги, архіви по даті, архіви по авторам і так далі. Подумавши і виявивши подібні сторінки, закрийте їх від індексації у файлі robots, прописавши Disallow: /stranica.

Якщо є якісь непонятки – запитуйте в коментарях. Повирішуємо.