Интернет ощущается…странно. Будь то TikTok, Facebook или просто поиск в Google, растущий поток низкокачественного, машинного контента захлестывает реальное человеческое выражение. Этот «мусор от ИИ», как его называют, — это спам новой эпохи социальных сетей: безликие посты, фейковые новости и сюрреалистические изображения, созданные для привлечения внимания, а не для информирования.

Этот термин появился в онлайн-сленге несколько лет назад, но теперь описывает масштабную проблему. Плохие мошеннические электронные письма были заменены бесконечным, низкоусильным выводом ИИ. Проблема не в том, что ИИ плохо создаёт; проблема в том, что слишком многие используют его для затопления сети бессмысленным наполнением.

Что именно такое мусор от ИИ?

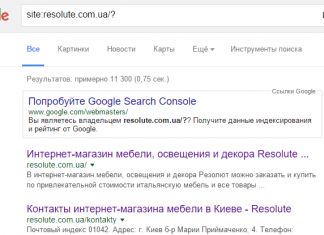

Слово «slop» изначально описывало дешёвый корм для животных. Сегодня оно передаёт то же ощущение низкокачественного наполнителя. Мусор от ИИ — это контент, сгенерированный быстро, небрежно и без учёта точности. Вы найдёте его повсюду: роботизированные закадровые повествования на YouTube поверх украденных кадров, «новости», написанные ИИ и скопированные с других сайтов, а также клипы TikTok с жутко синтетическими голосами. Даже результаты поиска засорены учебными пособиями и обзорами продуктов от ИИ, которые часто лишены реальной проницательности.

Проблема не в том, что ИИ плохо создаёт вещи; проблема в том, что люди используют его для массового производства контента ради кликов и доходов от рекламы. Как отмечает кинорежиссёр Шон Кинг О’Грейди, даже десятилетний ребёнок теперь может распознать подделки. Но это не останавливает распространение контента.

Мусор от ИИ против дипфейков и галлюцинаций: в чём разница?

Мусор от ИИ, дипфейки и галлюцинации размываются вместе, но их намерения и качества различаются.

- Дипфейки — это точные подделки, сделанные для обмана. Они убедительно изменяют видео или аудио, чтобы заставить кого-то казаться говорящим или делающим то, чего он никогда не делал. Цель — преднамеренная манипуляция, часто в политических или финансовых целях.

- Галлюцинации ИИ — это технические ошибки. Чат-боты выдумывают факты или судебные дела, потому что неправильно предсказывают следующее слово. Модель не пытается ввести в заблуждение; она просто терпит неудачу.

- Мусор от ИИ шире и небрежнее. Это массовое производство статей, видео, музыки и искусства без проверки фактов или связности. Его неточность возникает из-за пренебрежения, а не обмана.

Короче говоря: дипфейки обманывают намеренно, галлюцинации фабрикуют случайно, а мусор от ИИ затопляет интернет из равнодушия — часто ради жадности.

Почему мусор от ИИ распространяется?

Технология ИИ стала дешёвой и мощной очень быстро. Компании создавали эти модели в надежде снизить барьеры для творческих людей, но вместо этого они дали возможность контент-фермам массового масштаба. Инструменты, такие как ChatGPT, Gemini и Sora, позволяют любому генерировать текст, изображения и видео за секунды. В результате получается цифровой беспорядок, который засоряет ленты и приносит доход от рекламы.

Платформы также играют роль. Алгоритмы вознаграждают количество, а не качество. Чем больше вы публикуете, тем больше внимания получаете — даже если это чушь. ИИ делает масштабирование этой стратегии тривиальным. Некоторые создатели выдают фейковые новости знаменитостей или кликбейтные видео, набитые рекламой, в то время как другие перерабатывают контент от ИИ, чтобы обмануть рекомендации и привлечь трафик на малоэффективные сайты. Цель — не информировать; цель — выскребать доли цента за просмотр, умноженные на миллионы.

Как мусор от ИИ разрушает интернет

На первый взгляд, мусор кажется безвредным. Несколько плохих постов в вашей ленте могут даже быть забавными. Но объём меняет всё. Он опускает достоверные источники в результатах поиска, вытесняет человеческих создателей и размывает грань между правдой и фабрикацией. Когда половина того, что вы видите, выглядит поддельным, становится труднее доверять чему-либо.

Эта эрозия доверия имеет реальные последствия. Дезинформация распространяется быстрее, мошенники используют ИИ для выдачи себя за людей, а рекламодатели рискуют нанести ущерб бренду, появляясь вместе с низкокачественным контентом. Существует также более глубокая культурная цена. О’Грейди отмечает, что постоянное воздействие насилия и абсурда со временем притупляет нас.

Что можно сделать?

Быстрого решения не существует, но некоторые компании пытаются. Spotify маркирует контент, сгенерированный ИИ, а платформы, такие как Google и TikTok, обещают системы водяных знаков. Однако эти методы легко обходят с помощью скриншотов или переписываний.

Фреймворк C2PA внедряет метаданные в цифровые файлы для проверки их происхождения, но внедрение идёт медленно. Создатели также сопротивляются, подчёркивая человеческое мастерство и чётко указывая, когда ИИ не использовался.

Но в конечном счёте проблема не исчезнет. Как только массовое производство контента стало почти бесплатным, шлюзы открылись. ИИ не заботится о правде или оригинальности; он заботится о вероятности. И поэтому мусор от ИИ так легко сделать и так трудно избежать.

Лучшая защита — это осведомлённость. Замедлитесь, проверяйте источники и вознаграждайте создателей, которые всё ещё прикладывают реальные усилия. Интернет боролся со спамом и дезинформацией раньше. Мусор от ИИ — это просто последняя версия — более быстрая, более гладкая и труднее обнаруживаемая. Будет ли сохранена целостность сети, зависит от того, насколько мы ценим человеческую работу по сравнению с машинным выводом.